https://www.youtube.com/watch?v=-UIg00a_CD4

http://www.swedishmedtech.se/News.aspx?r_id=121390

Speaker: Anders Lansner,

Department of Computational Biology, School of Computer Science and

Communication, KTH and Stockholm University

When: Tuesday, February 21, 10:00 – 11:00AbstractThe

most advanced biological information processing system is the human

brain. It is an amazing and still partly mysterious organ that by far

outperforms man-made artifacts in tasks involving, for instance,

advanced perception and sensory-motor control. One possible path to

future human-like artificial intelligence is to mimic how the brain is

built and works. This development is promoted by the rapid progress in

neuroscience and brain research as well as in information technology

the current development towards massively parallel computer

architectures and hardware designs makes our computers more brain-like.

The aim of this talk is to discuss developments and technological

potentials of the fields of computational neuroscience and brain-like

computing. I will discuss state-of-the-art in modeling and supercomputer

simulation of the brain. I will also describe some research activities

aiming at brain-like computation and development of neuromorphic

hardware.

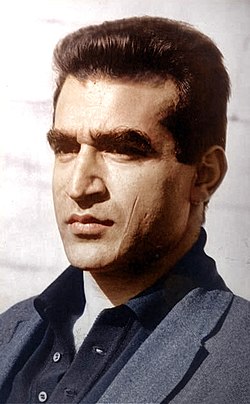

BiographyAnders Lansner

received his PhD in Computer Science from KTH 1986. He is presently

Professor in Computer Science at Dept of Computational Biology joint

between Stockholm University and KTH. He has for 30 years done research

in computational neuroscience and brain-inspired computing. He is

partner in several EU research projects on computational neuroscience

and neuromorphic engineering and member of the IT section of the Royal

Swedish Academy of Engineering Sciences (IVA).

https://www.sics.se/events/brain-ict-convergence-by-anders-lansner-kth-and-stockholm-university

Många användningsområden för sensornätverk

Datorerna har tagit klivet från skrivborden till våra fickor och nu fortsätter datakraften att sprida sig. Överallt får vi små sensorer som registrerar allt från luftföroreningar till våra egna hjärtslag. Effekterna blir drastiska men ännu är tekniken bara där internet var för 20 år sedan – vid starten på en lång osäker resa.

När lastbilen kör över bron vibrerar det. Vibrationerna fångas upp av en liten sensor som känner av om skakningarna tyder på att det håller på att bli en spricka.

Så håller det på dag efter dag ända tills sensorn verkligen märker att det blivit en spricka. Då går ett larm via mobilnätet och Trafikverket får skicka ut en ingenjör som kontrollerar saken.

Det här är ett av väldigt många scenarier för hur trådlösa sensornätverk kan användas. Men det är som sagt bara ett av många områden och i takt med att tekniken utvecklas och priserna faller räknar forskarna med att vår omgivning fylls av sensorer.

De är små, billiga och kan mäta allt från luftföroreningar till våra rörelser i hemmen. Framför allt kan de slå larm och berätta när någonting inte är som det ska.

De kommer dessutom i väldiga mängder. En siffra som ofta nämns, bland annat av Ericsson, är att det kommer att finnas 50 miljarder uppkopplade apparater 2020. Många är mobiler och datorer, men framför allt handlar det om en stor mängd sensorer som mäter allt möjligt.

Sensorerna kan dessutom ses som nästa stora steg i internets utveckling. Först var internet bara ett sätt att koppla ihop datorer. Nu ansluts allt fler mobiler och därefter är det dags för sensorerna.

Arbetet med trådlösa sensornätverk är ett ungt område där svenska forskare i Stockholm och Uppsala skaffat sig en bra position i Europa, vid sidan av de schweiziska kollegerna. Men som så ofta är det amerikanska forskare som går i täten och det försteget kan man spåra tillbaka till slutet av 1990-talet när det kom upp diskussioner om smart dust, intelligent damm.

Tanken var att militären från flygplan skulle kunna sprida ut tiotusentals små mätare över ett område. De skulle kopplas ihop trådlöst och för att sedan skicka tillbaka information om hur fienden rör sig, om det kommer farlig gas eller händer något annat som är viktigt att veta. Man skulle helt enkelt skapa ett moln över området som samlade in viktig information.

Sedan har tekniken tagit klivet över till den civila sidan och här arbetar forskarna med att försöka använda trådlösa sensorer på en rad olika områden. På sikt kan effekterna bli enorma och det hela påminner om hur det var när internet växte fram.

Även nätet började hos militären och de flesta hade länge svårt att föreställa sig vad tekniken skulle leda till. Idag har internet lett till drastiska förändringar på en rad olika områden.

–De trådlösa sensornätverken befinner sig ungefär på samma stadium som internet gjorde i slutet av 1980-talet, säger Adam Dunkels.

Han är forskare på datainstitutet SICS i Stockholm och har lyckats få en rad utmärkelser och bli en världskändis på området. Framför allt har han utvecklat operativsystemet Contiki som spelar en central roll i utvecklingen av trådlösa sensornätverk.

Eftersom sensorerna ska vara små och strömsnåla utgick man länge från att de krävde speciallösningar. Men Adam Dunkels utvecklade ett system för sensorer som bygger på samma teknik, ip, som används för att skicka data på internet.

Det gör också att man på ett förhållandevis enkelt sätt kan använda vilken dator eller internetansluten mobil som helst för att komma åt den information som en sensor lämnar ifrån sig. Förutsatt att man har rätt behörighet.

Sannolikt kommer just mobilen att framöver spela en central roll i sensornäten. Ett uppenbart skäl är att vi alltid har mobilen med oss och därför är det naturligt att de uppgifter som sensorerna samlar in visas där.

Mobilen är dessutom i sig en utmärkt insamlare av information. Den har kamera, mikrofon, rörelsesensorer, gps och annan teknik som kan registrera vad som händer runtomkring. Den kan också förses med sensorer som mäter luftföroreningar med mera.

Allt det här väcker också frågor kring den personliga integriteten. Vill vi verkligen ha sensorer som registrerar när vi kommer in i ett rum eller som ständigt övervakar vårt hjärta?

För en hjärtsjuk kan det vara tryggt att vara övervakad av en sensor som slår larm till läkaren om något händer. Men att någon annan via internet kan komma åt informationen känns inte bra.

–Den personliga integriteten är ett av de svåraste områdena. Det måste man vara medveten om när man utvecklar den här tekniken, säger Adam Dunkels.

Men det finns fler utmaningar. Priset på de trådlösa sensorerna måste ned, man måste ena sig om olika standarder, det krävs bättre batterier eller andra lösningar som kan ge sensorerna energi, och systemen måste bli mer stabila. Som Adam Dunkels uttrycker det har datorer en tendens att krascha och med trådlösa sensornätverk får vi en stor mängd datorer överallt. Och så måste man klara av att hantera de enorma datamängder som sensorerna skapar och knyta ihop de komplexa system som krävs om många miljarder datorer, mobiler och sensorer ska fungera ihop.

Biomedical Wireless Sensor Network

December 2007

• Advanced sensors combined with wireless communication

• Future opportunities for supporting mobility while monitoring vital body functions in hospital and home care

• Reduced costs, improved monitoring, and better life quality for the patient

http://www.sintef.no/project/Tradlospasient/Prosjekter/Biomedical%20Wireless%20Sensor%20Network%20(BWSN)_NICe%20report_web.pdf

http://www.sintef.no/project/Tradlospasient/Prosjekter/Biomedical%20Wireless%20Sensor%20Network%20(BWSN)_NICe%20report_web.pdf

The group was created by Prof Magnus Boman and Dr Lisa Brouwers in 2007 to meet the demand for investigations into computer-generated populations of individuals. In particular, investigations into the use of such populations for simulating complex processes, such as epidemic spread in space and time, was prompted by important real-life problems. While the concept of ‘individuals’ normally pertains to people, it could be generalized to denote animals, robots, viruses, or even trees, but processes governing spread are our primary concern.

In general, modeling people and their actions is very difficult, and any claims for adequacy must be carefully scrutinized. When using data on real people, such as demographics, the problem of maintaining the anonymity and personal integrity of each individual is added to the list of problems that need to be addressed. Even handling such databases requires extreme care and special permits for running simulations, because of the ethical dimension. If instead a synthetic population can be generated with the same, or at least very similar, properties as the original database, the synthetic population can replace the original one in simulations and other forms of manipulation.

The SyntPop group is strongly linked to S-GEM, which provides an agora for interdisciplinary research into epidemiological processes, not least through its seminars. Our own seminar series concentrates on the computer and systems science aspects of epidemiology and, as the name implies, synthetic populations in particular.

Det rör sig i våra hjärnor. Hjärncellerna är i ständig rörelse och pratar och lyssnar, säger Martin Garwicz, professor i neurofysiologi vid Lunds universitet. Vi vet mycket men måste förstå mycket mer om hur hjärnan fungerar för att kunna motverka nerv- och hjärnsjukdomar. Inspelat i juni 2013. Arrangör: Lunds universitet.

22:25Sändes:

tisdag 7 jan. 2014Tillgängligt t.o.m.

torsdag 13 mars. 2014

http://urplay.se/Produkter/177968-UR-Samtiden-Lundaforskare-forelaser-2013-Prata-med-hjarnan

Ethovision XT is an automated animal tracking system which can be used for tracking and analysing behaviour, movement and activity of an animal.

(Homo sapiens is also an animal)

Tänk dig en framtid där du hör om något spännande som du vill veta mer om. I stället för att gå till en dator trycker du bara på Google-knappen på din mobiltelefon. På dina glasögon projiceras då en bild över träffarna på Google för det som du tänkte på. Mobiltelefonen har redan registrerat dina tankar via en krets inopererad i hjärnan och vet vilket ämne du senast tänkt på. På den projicerade skärmen på glasögonens insida tittar du på den Google-träff du vill slå upp, och då skickar mobiltelefonen informationen uppläst till en elektronisk krets kopplad till dina hörselnerver.

Låter det som galen science fiction? Inte enligt Anders Sandberg, neurobiolog som just nu deltar i eu-projektet Enhance Project, där man undersöker etiska aspekter av alla dessa möjliga förbättringar av människan.

Jag bestämmer mig för att få höra hans syn på framtidens mobila människa och reser i väg till Oxford University där han just nu bedriver sin forskning i ett team knutet till den filosofiska institutionen.

När tåget från London närmar sig Oxford knappar jag in ett sms till Anders om när vi ska träffas. I framtiden kanske jag inte ens behöver knappa in bokstäverna. Framtidens t9 sitter i hjärnan, om man får tro forskare som Anders Sandberg.

För tre år sedan började 26-årige Matthew Nagles, som hade svåra skador på nervsystemet, kunna spela tvspel med hjärnan som fjärrkontroll. Det blev ett mycket konkret exempel på den forskning som görs där människans hjärna och nervsystem öppnas upp för anslutning till elektronik.

Forskningen presenterades i vetenskapstidskriften Nature och den visade hur en mycket liten inopererad krets i hjärnan kunde avläsa hans hjärnaktiviteter.

Matthew Nagle kunde i sin tur med hjälp av denna krets lära sig styra en markör på en datorskärm, spela datorspel, använda hjärnan som tv-fjärrkontroll och så småningom också styra en robot-arm så att han själv kunde koka sina potatisar.

Med hjärnan går det enligt forskarteamet också att skriva text på datorn, men i nuläget tar det dubbelt så lång tid som med ett vanligt tangentbord. På sikt kommer inmatning via hjärnimpulser förmodligen att gå snabbare än dagens tangentbordsskrivande, anser forskarna.

Redan i dag går det alltså att styra elektronik från hjärnan. Det är inte längre en fråga om science fiction. »Neurodevices« ses inom medicinsk affärsverksamhet som ett produktområde med snabb tillväxt. Företaget Cyberkinetics har redan varumärkesskyddat produkten Braingate där personer med hjärnskador kan styra sitt hem med hjärnan som fjärrkontroll.

I framtiden kommer mobiltelefonen att vara navet för vår mobila uppkoppling till internet och elektroniken i vår omgivning, menar neurobiologen Anders Sandberg när jag tack vare dagens primitiva sms-teknik lyckas träffa honom i Oxford:

– Mobiltelefonen kommer att bli den naturliga punkt som all den mobila elektroniken samlas kring.

I nuläget handlar utvecklingen om den här tekniken ofta om att kunna komma tillrätta med skadade och funktionshindrade människors problem, att möjliggöra styrning av kroppens nervsystem. Men när man väl lyckats ta reda på hur nervsystem och hjärna kan interagera med elektronik utanför kroppen öppnas ett helt nytt fält av möjligheter.

Att det är den här typen av rent medicinska tillämpningar som kommer först beror bland annat på att det är den typen av forskning som kan få finansiering. Att utveckla för att hjälpa sjuka och skadade är prioriterat inom medicinsk forskning. Utanför medicinen är det bara den amerikanska militären som via den militära forskningsmyndigheten Darpa anslår stora belopp på forskning för att förbättra och bygga ut mänskliga egenskaper, då för de amerikanska soldaterna.

– Många menar att medicin enligt definitionen bara får ägna sig åt att bota sjukdomar och skador. Men medicinen har redan länge gjort många människoförbättrande åtgärder som inte handlat om att bota sjukdomar. p-pillret är väl det mest frekvent använda exemplet, säger Anders.

Anders själv har Google-chipet som en favorit bland uppfinningarna som det talas om inför framtiden. En av Googles skapare, Larry Page, har själv väckt idén om ett sådant chip.

– Inför framtiden kan vi tänka oss att din hjärna blir avlyssnad av Google, till exempel att du tänker på ett ämne, och så kan din mobiltelefon viska svaret i ditt öra, sa Larry Page till nyhetsbyrån Reuters.

Det här uttalandet rönte en hel del uppmärksamhet, inte minst bland kommentatorer som avfärdade det hela som galet att vi skulle vilja genomgå en operation för att möjliggöra Google-sökningar från hjärnan.

Anders Sandberg tror inte att Google som funktion är det som kommer att bli den första funktionen för elektroniska kopplingar till hjärnan. Det är inte konstigare än att internet inte skapades för att vi ville ha Google. Det första syftet för internet var snarare väldigt praktiskt anpassat för akademiska och militära myndigheter.

På samma sätt utvecklas den teknik vi här talar om just nu för svårt funktionshindrade, men när tekniken förfinas kan den komma till oss »vanliga« människor också.

– Första chippet i hjärnan måste göra något mer än bara googla – mobilen kan ju göra det utmärkt från start utan kirurgi. Så grundfunktionen för ett sådant chip är snarast uppmärksamhetsstyrning

– dels märka vad man uppmärksammar, men dels också chansen att kontrollera graden av vakenhet och kanske rent av rikta in den. När man väl har en sådan funktion är ju Google-information en extra funktion man kan lägga in, liksom styrning av interfacet i mobilen, säger Anders Sandberg.

Att kunna se information visuellt via glasögon i stället för stora skärmar är en tanke som visats i både science fictionfilmer som »Robocop« och i reklamfilmer från kreditkortsföretag.

– Glasögonen kan mycket väl utvecklas till kontaktlinser med tiden. De kan också spara informationen man ser och hör i ens egen »livsdatabas« som man kan använda vid behov, menar Anders Sandberg.

Just det här med livsdatabaser är något vi kommer in på flera gånger under intervjun. Redan i dag ser vi hur människor lagrar sina minnen i text och bild på webbaserade databaser som Flickr och Gmail.

– Man kan tala om tre slags minnen här, dels det biologiska minnet i hjärnan, dels det privata lagringsminne som vi har på exempelvis Flickr, men också det kollektiva minnet som finns på webbsajter som Wikipedia, säger Anders.

Redan i dag blir det kollektiva minnet allt viktigare och länkas ihop med personliga lagringsminnen. På bildsajten Flickr kan bilder taggas med exempelvis platsen de är tagna. Utifrån en stor mängd Flickr-medlemmars bilder kan Flickr skapa en 3d-modell på skärmen från Notre Dame. All information kan lagras i enorma databaser, och den nya kunskap det kollektiva minnet får är hisnande.

– Mobilen är både länken till informationsvärlden och ett filter för den, samtidigt som den agerar ett lokalt utskott av ens datorresurser, av vilka huvuddelen ligger hemma eller hyrs online på Flickr, Gmail och så vidare.

Det är inte säkert att elektroniken behöver opereras in i kroppen. Niels Bir-baumer, en hjärnforskare vid Tübingens universitet i Tyskland har utvecklat en teknik för att läsa av hjärnverksamheten genom huden. Om den typen av teknik kommer att räcka för våra framtida önskemål om att vara uppkopplade till vår mobila elektronik vet vi förstås inte.

Men möjligheten att komma åt mobil teknik från hjärnan utan kirurgiska ingrepp är förstås ett spår som känns mindre långt borta.

Stu Wolf, forskare på den amerikanska militärens forskningsmyndighet Darpa, menar att vi i framtiden kommer att se på datorer på samma sätt som vi betraktar skrivmaskiner i dag. Framtidens motsvarighet till datorerna menar han kan byggas in i ett pannband som läser av hjärnaktiviteterna. Det går att interagera med hjärnan utan inbyggda elektroner.

När jag intervjuar Anders Sandberg kommer vi förstås också in på integritetsfrågor. rfid är en teknik som gör att alla möjliga föremål och levande varelser kan märkas och avläsas var de befinner sig, som ett slags streckkod, men i form av en radiosignal. rfid-taggar fästs redan i dag under huden på husdjur. Nyligen krävde företaget Citywatcher.com att vissa anställda skulle bära rfid-taggar under huden, som en extra säkerhetsåtgärd menade man eftersom rfid-utrustade passerkort kan komma på avvägar.

Vill verkligen människor ha rfidtaggar på sig som identifierar dem när de går förbi elektroniska enheter, som tunnelbanespärrar? Vill verkligen människor att elektroniska system ska ha koll på var de befinner sig, och kanske till och med att mobilen lagrar data om deras tankeverksamhet?

Det är inte första rfid-konflikten som seglat upp på senare år. Övervakningsproblemet med rfid-taggar har varit på tapeten en längre tid, inte minst sedan en skola i Kalifornien infört rfid-band som eleverna måste bära runt halsen, som ett sätt att öka säkerheten på skolan.

– Problemet med integritet har vi redan i dag. Nu när vi sitter på det här kaféet och dricker var sin kaffe är vi övervakade av mer än tre videokameror, säger Anders och pekar ut ett flertal övervakningskameror både utanför och inne på kaféet.

Tekniken erbjuder också möjligheter att styra över integritetsproblemen, menar Anders Sandberg:

– Vi kommer att vilja ha rfid-taggar i vårt privatliv. Just därför kommer vi också att använda mobilen som en brandvägg för att sätta gränser för intrång i integriteten. Vi kommer att kunna sätta spärrar för rfid-sökningar av oss från mobilens gränssnitt.

Men utvecklingen där människans möjligheter utökas med ny teknik har också fått många andra invändningar:

– Vissa menar att det här hotar den mänskliga naturen. Det är en invändning som är vanlig i usa. I Europa är den vanligare invändningen att det ökar ojämlikheten, att bara de som redan i dag har ekonomiska resurser kommer att ha råd med att ta del av den nya tekniken.

Det finns också en oro att vissa företag ska kunna kontrollera vårt tänkande.

– Antag att ett visst chip från Microsoft stör tankarna på gratisprogram som Linux, säger Anders Sandberg.

Enhance Project EU:s projekt för etisk granskning av människoförbättring

Miguel Nicolelis sida om forskning om hjärnan och minnet

BBC News 8 March 2013 Last updated at 11:55 GMT

Robots confused about what they encounter in the world of humans can now get help online.

European scientists have turned on the first part of a web-based database of information to help them cope.

Called Rapyuta, the online “brain” describes objects robots have met and can also carry out complicated computation on behalf of a robot.

Rapyuta’s creators hope it will make robots cheaper as they will not need all their processing power on-board.

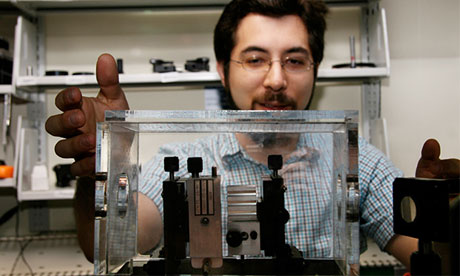

The Rapyuta database is part of the European Robo Earth project that began in 2011 with the hope of standardising the way robots perceive the human world.

Instead of every robot building up its own idiosyncratic catalogue of how to deal with the objects and situations it encounters, Rapyuta would be the place they ask for help when confronted with a novel situation, place or thing.

In addition, the web-based service is able to do complicated computation on behalf of a robot – for example if it needs to work out how to navigate a room, fold an item of clothing or understand human speech.

The system could be particularly useful for drones, self-driving cars or other mobile robots who have to do a lot of number crunching just to get round, said Mohanarajah Gajamohan, technical head of the project at the Swiss Federal Institute of Technology in Zurich.

Cloud control”On-board computation reduces mobility and increases cost.” said Dr Heico Sandee, Robo Earth program manager at the Dutch University of Technology in Eindhoven in a statement. As wireless data speeds increase more and more robotic thinking could be offloaded to the web, he said.

Without access to such a database, roboticists fear machines will be restricted to working in very tightly controlled environments such as production lines and never live easily alongside humans.

The project, which involves researchers at five separate European research labs, has produced the database as well as software that robots can run to connect to and quiz Rapyuta.

The name Rapyuta is taken from the Japanese film by Hayao Miyazaki Castle in the Sky – in the film it is the place where all the robots live.

09 FEBRUARY 2011, TECHNOLOGY

01 MARCH 2013, TECHNOLOGY

26 FEBRUARY 2013, TECHNOLOGY

14 FEBRUARY 2013, TECHNOLOGY

The BBC is not responsible for the content of external Internet sites

Intelligenta maskiner

Forskare studerar hur maskiner med moraliskt beteende kan skapas. Henrik Carlsen konstaterar att ett nytt forskningsområde vuxit fram: robotetik.

Inom robotetik (eller mer generellt maskinetiken som även innefattar så kallade expertsystem) är man intresserad av om, och i så fall hur, det är möjligt att säkerställa att robotar beter sig mot människor på ett etiskt försvarbart sätt. Hur man än ställer sig till om detta är möjligt är det svårt att värja sig mot det faktum att artificiella system är delaktiga i händelseförlopp som kan ha etiska konsekvenser. Inom vårdsektorn utvecklas i dag system som syftar till att hjälpa akutläkare att ställa diagnos under stressade förhållanden. Det finns också planer på att utveckla robotar för övervakning på flygplatser. I några fall är dessa robotar också avsedda för direkta fysiska ingripanden mot människor som uppträder på ett sätt som kan verka misstänkt.

Robotetiken behandlar två centrala frågeställningar: Vill vi att vissa beslut av moralisk karaktär ska tas över av maskiner och hur ska dessa maskiner i så fall konstrueras? Man kan givetvis fråga sig om det inte är för tidigt att diskutera dessa frågor då robotutvecklingen ännu är i sin linda. Många forskare argumenterar för att det trots allt är viktigt att redan på ett tidigt stadium integrera dessa aspekter både i teknologiutvecklingen och i lagstiftningen så att vi får ett samhälle där människor kan leva sida vid sida med ”intelligenta maskiner”.

I många sammanhang tas svaret på den första frågan som mer eller mindre givet: Marknaden och det politiska systemet kommer inte att kunna motstå de förtjänster som den nya teknologin för med sig och detta kommer i sin tur att leda till att människor i vissa situationer också är villiga att överlämna ansvaret till maskiner.

När det gäller den andra frågan finns i dag två konkurrerande teorier om hur etiska principer bäst byggs in i robotar. Enligt den första teorin – som ofta kallas top-down – ska robotar programmeras att handla enligt ett antal givna principer. Så snart man bestämt vilka regler som ger ”bäst” moraliskt uppträdande är det bara att skrida till verket och ge roboten instruktioner att agera enligt dessa regler. Det finns en rad olika moraliska system som skulle kunna utgöra kandidater för att implementeras i framtidens etiska robotar: religiösa ideal, kulturella principer eller moralfilosofiska teoribildningar. Tio Guds bud är ett exempel på ett religiöst ideal. Dessa system leder dock ofta till motsättningar mellan de olika regler man har att förhålla sig till och därför har forskningen inom denna del av robotetiken främst kommit att fokuseras på att analysera olika moralfilosofier.

På grund av sitt tydliga mål att maximera den totala nyttan har utilitarismen kommit att bli något av en favoritfilosofi bland top-down-orienterade robotetiker. Om den utilitaristiska roboten står inför en beslutssituation har den bara att för varje handlingsalternativ summera nyttan för varje påverkad individ och välja det alternativ som har högst summa. Roboten stöter dock på samma problem som vilken människa som helst som försöker leva efter utilitaristiska principer: Hur ska nyttan mätas? Ett annat problem rör hur långt in i framtiden roboten ska beakta konsekvenserna av sina handlingsalternativ: Ska effekter av beslut i dag på kommande generationer tas med i beräkningen?

Deontologiska teorier, där fokus ligger på motiven bakom ett handlande, har också attraherat robotetikers intresse och det talas ibland om roboten som den perfekta kantianen. Kanske är det endast en maskin som mäktar med det som Immanuel Kant begär av oss, det vill säga att handla så att ens handlande kan upphöjas till allmän lag.

Alternativet till att bygga etiska robotar via ett regelbaserat system brukar kallas bottom-up. Detta betraktelsesätt hämtar inspiration från observationen att moral är något vi lär oss. Efter år av successiv träning och inlärning kvalificerar sig de allra flesta människor för medlemskap i en grupp byggd kring en gemensam moraluppfattning. I motsats till top-down-teorier implementeras inte ett regelsystem i roboten, utan det moraliska beteendet utvecklas i samspel med omgivningen.

Ursprunget till denna idé kan spåras tillbaka till en uppsats från 50-talet av Alan Turing, en av datalogins djupaste tänkare och samtidigt den brittiska underrättelsetjänstens skarpaste kodknäckare under andra världskriget. Uppsatsen inleds med en mening som har kommit att bli klassisk: ”I propose to consider the question, ’Can a machine think?’”. Frågan handlar om vad en maskin är, vad en maskin kan, men framför allt handlar uppsatsen om vad det innebär att tänka. Turing för här fram idén att i stället för att försöka skapa ett program som simulerar den vuxnas medvetande, kan man skapa ett program som simulerar ett barns medvetande. Om detta program sedan genomgår träning och successiv utveckling så skulle man erhålla något som liknar den vuxnes hjärna. Med inspiration från Turings idé har man börjat tala om evolutionär robotik. Hittills har dessa strategier mest kommit att tillämpas på att lära robotar mer triviala ting än moraliskt uppträdande, exempelvis förflyttning eller navigation i främmande miljöer, men förhoppningar finns om att nyttja liknande strategier för att utveckla högre kognitiva färdigheter.

Evolutionär robotik är, hävdar vissa forskare, en nödvändighet för att uppnå någon som helst grad av autonomt agerande hos framtidens robotar. Den ”läroprocess” som roboten då måste genomgå innebär nya utmaningar kring ansvarsutkrävande i samband med olyckshändelser där tekniska system varit inblandade. Traditionellt talar man om producentansvar och användaransvar. Enkelt uttryckt: Om användaren följt instruktionsboken faller ansvaret på producenten, medan användaren är ansvarig då olyckan orsakats av felaktigt nyttjande. En livaktig diskussion kring framtida autonoma system är huruvida detta – mycket förenklade – förhållande kan komma att utmanas då en tredje aktör införs i ansvarskedjan. Förutom producenten och användaren vid tillfället för tillbudet tillkommer då alla de användare som bidragit till att utbilda roboten genom inlärning i olika typer av miljöer och därmed varit med och påverkat dess utveckling. Det är lätt att tänka sig den ökade komplexitet som följer av att alla tidigare användare, tillsammans med tillverkaren, ska hållas ansvariga för en robots förehavanden.

Top-down respektive bottom-up representerar två ytterligheter i frågan om hur moraliskt beteende kan byggas in i maskiner. Analogt med hur man inom biologin talar om arv och miljö anser de flesta robotforskare att en kombination av de två ansatserna kommer att behövas om man över huvud taget ska nå någon framgång inom området.

När man talar om relationer mellan människor och maskiner är det i själva verket flera olika relationer som avses. Helt naturligt har maskinetiken kommit att fokusera på problemet kring hur maskiner som agerar etiskt i förhållande till människor kan byggas. Det är ingen överdrift att påstå att 99 procent av arbetet inom området berör detta problem. En naturlig följdfråga är hur människor etiskt bör förhålla sig till maskiner. Intuitivt kan denna frågeställning verka märklig, men i takt med större möjligheter att bygga avancerade maskiner kommer även denna frågeställning att aktualiseras.

Såsom i fallet med webbens framväxt visar sexindustrin ett intresse för den nya teknologins möjligheter. I januari förra året visades vad som påstås vara den första sexroboten. Enligt reklamen kan Roxxxy både föra enklare samtal och få (robot)orgasm. Företaget bakom Roxxxy arbetar nu även med att utveckla den manliga varianten, Rocky.

Även om redan detta utmanar några av våra föreställningar om vad som är etiskt försvarbart så dyker de verkliga problemen upp då Roxxxys mindre varianter lanseras. En inte allt för vågad gissning är att barnvarianten redan är under utveckling. Är det etiskt försvarbart att ha sex med en robot som liknar ett barn? En vanlig argumentationslinje går ut på att dessa robotar skulle kunna få pedofiler att avstå från övergrepp på barn. I uppsatsen Virtual child pornography and utilitarianism analyserar filosofen Per Sandin frågan om den tekniska utvecklingen kan komma att tvinga oss att förändra en del av den moraliska argumentationen i debatten kring barnpornografi. Det vanligaste argumentet är att barn tar skada i framställningen av barnpornografi. Självfallet saknar detta argument grund i det virtuella fallet. Sandins argumentation kan överföras till sexrobotar som liknar barn, dock tror jag de allra flesta upplever situationen som (än) mer provocerande i fallet med en robot än ett datorprogram.

Den kanske allra mest grundläggande, och på lång sikt avgörande, frågan är hur samhället kommer att reagera på införandet av ”intelligenta” maskiner. Till avgörande del bestämmer existerande moraliska principer hur nya teknologier tas upp i samhället. Samtidigt är det viktigt att erinra sig att dagens moraliska teorier utvecklades långt innan autonomt agerande maskiner var tilltänkta. De nya teknologiernas möjligheter utmanar i vissa fall rådande moralparadigm; fildelningsdebatten utgör här ett färskt exempel. Är det så att vi på sikt får en utveckling där det moraliska system som är möjligt att implementera i robotar blir den allenarådande i samhället i stort? Kan teknologin på detta sätt få ett medbestämmande över samhällets moral?

Alan Turing drevs av nyfikenhet kring vad en maskin egentligen är. Jeanette Winterson vänder delvis på perspektivet i romanen Stengudarna och utforskar vad det innebär att vara människa genom att låta människan speglas i och utmanas av en nära avbild av henne, Robo sapiens. Vad definierar en människa? När upphör en människa att vara en människa? När blir en maskin en människa? Frågan om gränsdragningar kan i dag kännas trivial. Men i framtiden kommer robotarna att bli allt mer människolika samtidigt som vi kommer att bli allt mer robotlika, dels via olika typer av implantat som delar teknologi med robotarna men också via en socialiseringsprocess där vi lär oss att umgås med robotar. I den mån vi över huvud taget i framtiden kan tala om oss själva som en distinkt art, måste vi då kanske ta i den svåraste frågan av dem alla: Behövs vi? Det är endast den art som står högst upp i hierarkin som slipper motivera sin existens.

Henrik Carlsen

är filosofie doktor och forskningsledare vid Totalförsvarets forskningsinstitut, FOI. Han intresserar sig mest för klimatförändringarnas effekter på samhället och för teknikutveckling och social förändring.

http://www.unt.se/kultur/essa/manniska-eller-maskin-1510211.aspx

PTS deltar i flera forskningsprojekt. Här finns information om några av dessa projekt.

Wireless@KTH är ett forskningscenter inom området Mobila system och tjänster. Centret arbetar tillsammans med forskare från KTH och industriella partners för att utveckla mobila system och tjänster, vilket är ett kärnområde för Sverige och Stockholm.

Wireless@KTH är involverat i interdisciplinära forskningsprojekt i samarbete med den akademiska världen och industrin. Ett viktigt område för centret är att överbrygga klyftan mellan utvecklingen av system och tjänster och deras kommersiella införande.

PTS är sedan ett antal år tillbaka s.k. Associate Partner med Wireless@KTH. Detta innebär bl.a. att PTS deltar i vissa forskningsprojekt, framförallt sådana som berör effektivt spektrumutnyttjande, och även att PTS bjuds in till seminarier och får ta del av aktuella och intressanta forskningsresultat. PTS breddar även genom sitt deltagande kontaktnätet med branschen och den akademiska världen.

I januari 2008 startade ett treårigt projekt benämnt MODyS(Multioperator Dynamic Spectrum Management) i vilket PTS deltar. Syftet med projektet är att utveckla detaljerade tekniska mekanismer för dynamisk access till spektrum i miljöer med många operatörer. Lite förenklat kan det även uttryckas som hitta metoder för att ”på en viss plats kunna nyttja det spektrum som för tillfället inte används av någon annan”. Övriga deltagare i projektet är Ericsson och Försvarets forskningsanstalt, FOI. Från PTS sida deltar Urban Landmark.

PTS är under 2008-2010 engagerad i två EU-drivna forskningsprojekt i det 7:e ramprogrammet, som leds av universitetet i Valencia, Spanien. Projekten benämns UCELL (Ultra wideband realtime interference monitoring and cellular management strategies) och UBRAIN (Ultra wideband car safety simultaneous radar and communications photonic integration).

Båda projekten syftar till att förbättra möjligheterna och applikationerna för system baserade på ultra wideband-teknik. UCELL är inriktat på applikationer som förbinder UWB-utrustningar till sammanhängande system i cellliknande strukturer. UBRAIN är inriktat på användningen av UWB-teknik i fordons- och vägtrafiktillämpningar. PTS bidrag i projekten består i första hand av deltagande i en regulatorisk expertpanel.

Syftet med deltagandet är att inhämta ytterligare kunskap om UWB-tekniken och dess användningsområden som kan förväntas få en bredare spridning de kommande åren och vars påverkan på andra kommunikationssystem fortfarande är relativt okänd. Från PTS sida deltar Urban Landmark.

Det låter som en kemisk dekokt ur tv-serien ”Breaking bad”. Men smart dust – intelligent damm – är i själva verket mycket små och enormt många trådlöst uppkopplade sensorer som registrerar allt vi ber dem om.

Bilars position och kommunikation med andra bilar, sprickbildningar på en bro, köbildning, folkmassor, vad du vill. Dessa allomfattande data lagras i molnet.

Svärmen av sensorer uppfattar också när du viftar på handen, för det är så du i framtiden får tillgång till internet. Dagens bärbara plattor och mobiler kommer inte att behövas.

Det är i alla fall en vision som Swarm Lab på Berkeleyuniversitetet i USA har som mål att förverkliga. Tekniken beskrivs i senaste numret av framtidsmagasinet Next som görs av oss på Ny Tekniks redaktion. Vår telekomreporter Helen Ahlbom intervjuar professor Jan Rabaey som berättar om en planerad konferens där han ska strömma video och ljud till olika bildskärmar och högtalare, bara genom att lyfta handen.

Jan Rabaey tror att det finns en miljon miljoner trådlöst uppkopplade sensorer år 2025. Bara han och kollegorna lyckas med utmaningen att konstruera ett öppet operativsystem så det intelligenta dammet – sensorsvärmarna – kan kommunicera.

Hisnande perspektiv, eller hur?

Kanske är Jan Rabaey ändå inte överoptimistisk i sin tidsbedömning. Arbetet med nästa generation mobilnät, 5g, är redan i full gång. Den här gången handlar det inte bara om högre datakapacitet för mobiltelefoni, utan om helt nya funktioner.

Framför allt är det prylar – allt från bilar och industrirobotar till delar av elnät – som ska kommunicera med varandra. Över 500 miljarder uppkopplade prylar år 2030 är en siffra som cirkulerar, även den är hisnande.

För att klara den stora efterfrågan på datatrafik i mobilnäten räcker det inte att bara bygga fler och större basstationer. Helen Ahlbom berättar på sidorna 14– 15 om ett projekt att i stället placera basstationer i bilar, bussar och tåg. Ett flexibelt sätt att skapa mobiltäckning där det tillfälligt behövs.

Allt som oftast rapporterar Ny Teknik om tekniska lösningar som känns svindlande i dag. Men några år senare tar vi dem för givna.

Publicerad 22 januari 2014 10:20 av Susanna Baltscheffsky

http://www.nyteknik.se/asikter/ledare/article3799243.ece?service=mobile

Av Adam Edström (adam@etn.se)

| (2001-09-27 14:48:00 UTC) Stockholm får snart ett nytt forskningscentrum för så kallad kortikotronik, eller hjärnelektronik på svenska. Centrumet ska drivas av Karolinska Institutet med stöd från Ericsson och finansiering från stiftelsen för strategisk forskning.

Hur hanterar hjärnan kommunikationsfrågor? Hur ser hjärnans nätverksarkitektur ut? Hur kan sådan kunskap tillämpas på mobiltelefonsystem? Och hur kan telekomutvecklarnas erfarenhet av modellering hjälpa hjärnforskarna att förstå hjärnans beteende? Dessa frågor ska forskare från Karolinska Institutet nu försöka svara på i ett projekt kallat “Cortical dynamics and corticotronics for telecommunication systems”.Bakom projektet står professorerna Per Roland och Giorgio Innocenti vid institutionen för neurovetenskap på Karolinska Institutet, samt Jan Johansson på Ericsson Research. Ericsson ska stötta projektet med 3 miljoner kronor under tre år, och lika mycket pengar ska komma från stiftelsen för strategisk forskning.- Målet är att försöka förstå hjärnans sätt att lösa kommunikationsfrågor och kopiera detta i elektroniska system. Det är ett högriskprojekt, som dock öppnar för nya perspektiv och samarbetsytor mellan telekommunikationsföretag och neurvetenskap, sammanfattar stiftelsens planeringschef Olle Edqvist.

I projektet ska tre nivåer i hjärnan studeras – enskilda neuroner och hur de samverkar, grupper av neuroner och hur de samverkar, samt hela hjärnan som samlat system. Detta är områden som professorerna Roland och Innocenti har stor erfarenhet av. Ericsson hoppas få konkret nytta av resultaten inom mobiltelefoni. När mobiltelesystemen når en miljard samtidiga användare – vilket kommer att inträffa inom några år – så behövs nya system för att i realtid lokalisera telefonerna och koppla samtalen. System med dagens teknik skulle bli alldeldes för stora, dyra och komplexa – Ericsson hoppas kunna utveckla flexibla och självlärande system som kan hantera uppgiften på ett mer dynamiskt sätt än idag. Principerna och modellerna som forskarna förhoppningsvis får fram ska alltså studeras, testas och i möjligaste mån användas av Ericssons konstruktörer. Ericsson har också tagit på sig uppgiften att demonstrera modeller av allt från enskilda neuroner till hela hjärnor i verkliga halvledare. FPGA-kretsar, nätverk på kisel och så kallade flex-asic nämns i ansökan som möjliga tekniker för implementering. Det låter lite science-fictionartat, men tanken är faktiskt inte att bygga några artificiella hjärnor som ska styra teletrafiken. För på flera områden är tekniken redan idag överlägsen hjärnan. Forskarnas ambition är snarare att identifiera de områden där hjärnan är överlägsen, och undersöka om och i så fall hur funktioner på dessa områden kan medverka till bättre telekomsystem. Adam Edström © Elektroniktidningen (www.etn.se)

http://etn.se/15616 |

Hjärnvågor avslöjar vilka ord som rör sig i huvudet.

Röster i huvudet. Forskning om hjärnaktiviteten i den lyssnande hjärnan kan ge totalförlamade nya möjligheter att uttrycka sig.

Structure, säger en mansröst på engelska. En sekund senare upprepar en dator samma ord, grötigt men hörbart. Datorns tal bygger helt och hållet på elektriska signaler från tinningloben, den del av hjärnan där det talade språket analyseras.

Öronen omvandlar ljudet till nervsignaler som hjärnan sedan bearbetar i flera steg. Tidigare forskning har visat att hjärnaktiviteten hos en person som hör något till stora delar liknar aktiviteten hos den som bara föreställer sig samma ljud. Det innebär att den nya metoden skulle kunna göra det möjligt att avlyssna outtalade meningar direkt från hjärnan, skriver amerikanska forskare i tidskriften Plos Biology.

De studerade hjärnan på femton patienter som skulle opereras på grund av svår epilepsi eller hjärntumör. Kirurgerna fäste ett rutnät av elektroder utanpå tinningloben hos varje patient för att ta reda på exakt vilket område som bearbetar språket. Syftet var att undvika skador på språket under operationen.

Forskarna använde samma elektroder till att mäta den elektriska aktiviteten som uppstod i hjärnan på patienterna när de hörde en lista av ord. I nästa steg fick en dator omvandla signalen till ljud.

Om allt fungerar som forskarna hoppas skulle tekniken kunna leda till att en människa instängd i en förlamad kropp kan tala, trots att inga muskler fungerar.

http://fof.se/tidning/2012/3/vart-tal-kan-avlyssnas-med-elektroder-i-hjarnan

Forskare har använt gammal teknik för att skapa vad de kallar en “tankeläsningsmaskin”. Med elektroder placerade direkt på hjärnan kan en dator registrera exakt vilket ord en försökspersonen tänker på.

14 maj 2011 kl 20:51 , uppdaterad: 15 maj 2011 kl 09:48

Tekniken kallas ECoG (electrocorticography) och innebär att elektroder placeras under kraniet och hjärnhinnan direkt på själva hjärnan.

ECoG har använts sedan 1950-talet för att dokumentera vilken del av hjärnan som aktiveras vid exempelvis ett epilepsianfall. De senaste åren har elektroderna använts för att med hjärnans hjälp styra proteser.

Men det senaste forskningsområdet är att med hjälp av ECoG visa hur hjärnan behandlar språket och även avkoda våra tankar.

Forskare vid amerikanska Wadsworth Center uppger nu att de kan kombinera tekniken med modern programvara för att på en dator se vilket ord en försöksperson tänker på.

– Det här är både väldigt spännande och samtidigt lite skrämmande. Vi kommer verkligen ganska nära vad människor brukade kalla tankeläsning, säger Gerwin Schalk till radiostationen NPR.

Bland annat kan forskarna följa vad som händer i hjärnan när ett musikstycke spelas och visa att samma hjärnaktivitet upprepas om musiken spelas igen. Datan visar också på samma aktivitet när patienter bara tänker på musikstycket.

– Hjärnan berättar egentligen mer om musiken under de tidpunkter då det inte spelas någon musik, säger Schalk.

Anledningen till att ECoG är så effektivt är att tekniken plockar upp signaler från flera olika delar av hjärnan.

Elektroder som placeras inne i hjärnan är precisa men har bara kontakt med ett visst område. Elektroder utanpå huden håller kontakt med stora områden men där blir informationen inte lika specifik.

ECoG som ligger någonstans mitt emellan innebär en idealisk medelväg. Ett kirurgiskt ingrepp krävs för att placera elektroderna men inget ingrepp görs på själva hjärnan.

Neurokirurgen Eric Leuthardt som arbetat tillsammans med Gerwin Schalk på projektet säger att framsteg på området nu sker i rasande takt.

– Varannan vecka hittar vi något som verkligen får oss att klia oss i huvudet och tycka att vi hittat något häftigt.

http://www.svd.se/nyheter/utrikes/forskare-har-skapat-tankelasningsmaskin_6165203.svd

Eva Åstradsson, sjuksköterska, Universitetssjukhuset i Linköping

- Det var spännande och det stämmer att vi måste kommunicera mer med varandra över gränserna. Jag ser dagligen hur vi stänger in oss i våra organisationer. Vi tänker på organisationen i första hand och inte på det bästa för patienterna. Vi gör det för vi vill vara duktiga men samhället har en annan förväntasbild.

Pär Näverskog, ST-läkare i internmedicin vid Södersjukhuset i Stockholm och ledamot i SYLF-styrelsen.

- Det var intressant. Den erfarenhet jag har är att vården har svårt att ta till sig innovation och nya arbetssätt. Många försöker få fram ny teknik men vi implementerar den inte. Vi måste lära oss att förstå varandra och våra olika kompetenser och vi inom vården måste bli duktiga på att beskriva våra problem.

Läs om del ett av seminariet: Konstgjord livmoder snart inte science fiction längre

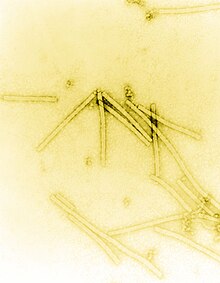

Smartdust is a system of many tiny microelectromechanical systems (MEMS) such as sensors, robots, or other devices, that can detect, for example, light, temperature,vibration, magnetism, or chemicals. They are usually operated on a computer network wirelessly and are distributed over some area to perform tasks, usually sensing throughradio-frequency identification. Without an antenna of much greater size the range of tiny smart dust communication devices is measured in a few millimeters and they may be vulnerable to electromagnetic disablement and destruction by microwave exposure.

The concepts for Smart Dust emerged from a workshop at RAND in 1992 and a series of DARPA ISAT studies in the mid-1990s due to the potential military applications of the technology.[1] The work was strongly influenced by work at UCLA and the University of Michigan during that period, as well as science fiction authors Neal Stephenson and Vernor Vinge. The first public presentation of the concept by that name was at the American Vacuum Society meeting in Anaheim in 1996.

A Smart Dust research proposal[2] was presented to DARPA written by Kristofer S. J. Pister, Joe Kahn, and Bernhard Boser, all from the University of California, Berkeley, in 1997. The proposal, to build wireless sensor nodes with a volume of one cubic millimeter, was selected for funding in 1998. The project led to a working mote smaller than a grain of rice,[3] and larger “COTS Dust” devices kicked off the TinyOS effort at Berkeley.

The concept was later expanded upon by Kris Pister in 2001.[4] A recent review discusses various techniques to take smartdust in sensor networks beyond millimeter dimensions to the micrometre level.[citation needed]

The Ultra-Fast Systems component of the Nanoelectronics Research Centre at the University of Glasgow is a founding member of a large international consortium which is developing a related concept: smart specks.[5]

The term roboethics was coined by roboticist Gianmarco Veruggio in 2002, who also served as chair of an Atelier funded by the European Robotics Research Network to outline areas where research may be needed. The road map effectively divided ethics of artificial intelligence into two sub-fields to accommodate researchers’ differing interests:[1]

[hide]

Robotics is rapidly becoming one of the leading fields of science and technology, so that very soon humanity is going to coexist with a totally new class of technological artifacts: robots. It will be an event rich in ethical, social and economic problems. “Roboethics is an applied ethics whose objective is to develop scientific/cultural/technical tools that can be shared by different social groups and beliefs. These tools aim to promote and encourage the development of Robotics for the advancement of human society and individuals, and to help preventing its misuse against humankind.” (Veruggio, 2002)[1] It is the first time in history that humanity is approaching the challenge to replicate an intelligent and autonomous entity. This compels the scientific community to examine closely the very concept of intelligence — in humans, animals, and of the mechanical — from a cybernetic standpoint.

In fact, complex concepts like autonomy, learning, consciousness, evaluation, free will, decision making, freedom, emotions, and many others shall be analyzed, taking into account that the same concept shall not have, in humans, animals, and machines, the same reality and semantic meaning.

From this standpoint, it can be seen as natural and necessary that robotics drew on several other disciplines, like Logic, Linguistics, Neuroscience, Psychology, Biology,Physiology, Philosophy, Literature, Natural history, Anthropology, Art, Design. Robotics de facto unifies the so-called two cultures, science and humanities. The effort to design Roboethics should take care of this specificity. This means that experts shall view robotics as a whole — in spite of the current early stage which recalls a melting pot — so they can achieve the vision of the robotics’ future.

Since the First International Symposium on Roboethics (Sanremo, Italy, 2004), three main ethical positions emerged from the robotics community (D. Cerqui, 2004):

The design of Roboethics requires the combined commitment of experts of several disciplines, who, working in transnational projects, committees, commissions, have to adjust laws and regulations to the problems resulting from the scientific and technological achievements in Robotics and AI.

In all likelihood, it is to be expected that the birth of new curricula studiorum and specialties, necessary to manage a subject so complex, just as it happened with Forensic Medicine. In particular, the main fields involved in Roboethics are: robotics, computer science, artificial intelligence, philosophy, ethics, theology, biology, physiology, cognitive science, neurosciences, law, sociology, psychology, and industrial design.

As Roboethics is a human-centered ethics, it has to comply with the principles state in the most important and widely accepted Charters of Human Rights:

Roboethics shares with the other fields of science and technology most of the ethical problems derived from the Second and Third Industrial Revolutions:

| Laws of robotics |

|---|

| Three Laws of Robotics by Isaac Asimov (in culture) |

| Related topics |

|

Since antiquity, the discussion of ethics in relation to the treatment of non-human and even non-living things and their potential “spirituality” have been discussed. With the development machinery and eventually robots, this philosophy was also applied to robotics. The first publication directly addressing roboethics was developed by Isaac Asimov as his Three Laws of Robotics in 1942, in the context of his science fiction works, although the term “roboethics” was created by Gianmarco Veruggio in 2002.

The Roboethic guidelines were developed during some important robotics events and projects:

Roboethics as a science or philosophical topic has not made any strong cultural impact,[citation needed] but is a common theme in science fiction literature and films. One of the most popular films depicting the potential misuse of robotic and AI technology is The Matrix, depicting a future where the lack of roboethics brought about the destruction of the human race. An animated film based on The Matrix, the Animatrix, focused heavily on the potential ethical issues between humans and robots. Many of the Animatrix’s animated shorts are also named after Isaac Asimov’s fictional stories. The movie I, Robot (named after Isaac Asimov’s book I, Robot) also depicts a scenario where robots rebel against humans due to the lack of civil rights and ethical treatment.

Although not a part of roboethics per se, the ethical behavior of robots themselves has also been a joining issue in roboethics in popular culture. The Terminator series focuses on robots run by an uncontrolled AI program with no restraint on the termination of its enemies. This series too has the same futuristic plot as The Matrix series, where robots have taken control. The most famous case of robots or computers without programmed ethics is HAL 9000 in the Space Odyssey series, where HAL (a computer with advance AI capabilities who monitors and assists humans on a space station) kills all the humans on board to ensure the success of the assigned mission.

Simulering av ljudtrycket för vokalen “i” i en starkt förenklad modell av ansatsröret. Foto: KTH

Simulering av ljudtrycket för vokalen “i” i en starkt förenklad modell av ansatsröret. Foto: KTH Stegvisa förenklingar av huvudets yttre form används för att räkna ut ljudutbredningen utanför munnen. Foto: KTH

Stegvisa förenklingar av huvudets yttre form används för att räkna ut ljudutbredningen utanför munnen. Foto: KTH För att studera hur röstljuden skapas och fortplantas i kroppen används biomekaniska datormodeller. Foto: KTH

För att studera hur röstljuden skapas och fortplantas i kroppen används biomekaniska datormodeller. Foto: KTH Simulering av en tryckpuls på väg ut ur munnen. Foto: KTH

Simulering av en tryckpuls på väg ut ur munnen. Foto: KTHKTH-forskare tar superdatorn Lindgren till hjälp i simuleringar som ska avslöja talorganens dolda hemligheter. Målet är en röstmaskin som kan tala alla språk och sjunga med olika sångtekniker

I april gick startskottet för EU-projektet Eunison. Med 25 miljoner i pengapåsen ska forskare vid fem universitet kartlägga den mänskliga rösten i detalj. Forskare vid KTH leder projektet.

-Människorösten är komplicerad och vi behöver bättre förståelse för hur den fungerar, säger Sten Ternström, professor i musikakustik vid KTH.

Fysiken bakom hur vi människor talar och sjunger handlar om komplexa samband mellan olika delorgan, som hittills studerats var för sig. Nu har datorkapaciteten blivit tillräckligt stor för att man ska kunna simulera hela röstorganet. På KTH tar forskarna superdatorn Lindgren till hjälp.

-Det handlar visserligen i grunden om rätt enkla fysikaliska samband och de fyra räknesätten, men samtidigt är det snabba rörelser hos tiotusentals punkter i tre dimensioner vi talar om. Det gör forskningen beräkningstung.

Målet med projektet är en röstmodell som ska gå att använda via internet. Och som ska kunna styras till att tala alla språk och sjunga på olika sätt.

På sikt hoppas Sten Ternström att forskningen ska leda till maskiner som talar, talproteser samt bättre metoder att undervisa i hur man använder rösten och vårdar den.

http://www.nyteknik.se/nyheter/innovation/forskning_utveckling/article3692143.ece

Ubiquitous computing (ubicomp) is an advanced computing concept where computing is made to appear everywhere and anywhere. In contrast to desktop computing, ubiquitous computing can occur using any device, in any location, and in any format. A user interacts with the computer, which can exist in many different forms – laptop, tablets, terminals, phones, etc. The underlying technologies to support ubiquitous computing include Internet, advanced middleware, operating system, mobile code, sensors, microprocessors, new I/O (input / output), new user interfaces, networks, mobile protocols, location and positioning, new materials, etc.

This new paradigm is also described as pervasive computing, ambient intelligence,[1] or, more recently, everyware,[2] where each term emphasizes slightly different aspects. When primarily concerning the objects involved, it is also physical computing, the Internet of Things, haptic computing,[3] and things that think. Rather than propose a single definition for ubiquitous computing and for these related terms, a taxonomy of properties for ubiquitous computing has been proposed, from which different kinds or flavors of ubiquitous systems and applications can be described.[4]

At their core of all models of ubiquitous computing share a vision of small, inexpensive, robust networked processing devices, distributed at all scales throughout everyday life and generally turned to distinctly common-place ends. For example, a domestic ubiquitous computing environment might interconnect lighting and environmental controls with personal biometric monitors woven into clothing so that illumination and heating conditions in a room might be modulated, continuously and imperceptibly. Another common scenario posits refrigerators “aware” of their suitably tagged contents, able to both plan a variety of menus from the food actually on hand, and warn users of stale or spoiled food.

Ubiquitous computing presents challenges across computer science: in systems design and engineering, in systems modelling, and in user interface design. Contemporary human-computer interaction models, whether command-line, menu-driven, or GUI-based, are inappropriate and inadequate to the ubiquitous case. This suggests that the “natural” interaction paradigm appropriate to a fully robust ubiquitous computing has yet to emerge – although there is also recognition in the field that in many ways we are already living in an ubicomp world. Contemporary devices that lend some support to this latter idea include mobile phones, digital audio players, radio-frequency identification tags, GPS, and interactive whiteboards.

Mark Weiser proposed three basic forms for ubiquitous system devices, see also Smart device: tabs, pads and boards.

These three forms proposed by Weiser are characterized by being macro-sized, having a planar form and on incorporating visual output displays. If we relax each of these three characteristics we can expand this range into a much more diverse and potentially more useful range of Ubiquitous Computing devices. Hence, three additional forms for ubiquitous systems have been proposed:[4]

In his book The Rise of the Network Society, Manuel Castells suggests that there is an ongoing shift from already-decentralised, stand-alone microcomputers and mainframes towards entirely pervasive computing. In his model of a pervasive computing system, Castells uses the example of the Internet as the start of a pervasive computing system. The logical progression from that paradigm is a system where that networking logic becomes applicable in every realm of daily activity, in every location and every context. Castells envisages a system where billions of miniature, ubiquitous inter-communication devices will be spread worldwide, “like pigment in the wall paint”.

Ubiquitous computing may be seen to consist of many layers, each with their own roles, which together form a single system:

Layer 1: task management layer

Layer 2: environment management layer

layer 3: environment layer

Mark Weiser coined the phrase “ubiquitous computing” around 1988, during his tenure as Chief Technologist of the Xerox Palo Alto Research Center (PARC). Both alone and with PARC Director and Chief Scientist John Seely Brown, Weiser wrote some of the earliest papers on the subject, largely defining it and sketching out its major concerns.[5][6][7]

Recognizing that the extension of processing power into everyday scenarios would necessitate understandings of social, cultural and psychological phenomena beyond its proper ambit, Weiser was influenced by many fields outside computer science, including “philosophy, phenomenology, anthropology, psychology, post-Modernism, sociology of science and feminist criticism“. He was explicit about “the humanistic origins of the ‘invisible ideal in post-modernist thought’”,[7] referencing as well the ironically dystopian Philip K. Dick novel Ubik.

Andy Hopper from Cambridge University UK proposed and demonstrated the concept of “Teleporting” – where applications follow the user wherever he/she moves.

Roy Want, while a researcher and student working under Andy Hopper at Cambridge University, worked on the “Active Badge System”, which is an advanced location computing system where personal mobility that is merged with computing.

Bill Schilit (now at Google) also did some earlier work in this topic, and participated in the early Mobile Computing workshop held in Santa Cruz in 1996.

Dr. Ken Sakamura of the University of Tokyo, Japan leads the Ubiquitous Networking Laboratory (UNL), Tokyo as well as the T-Engine Forum. The joint goal of Sakamura’s Ubiquitous Networking specification and the T-Engine forum, is to enable any everyday device to broadcast and receive information.[8][9]

MIT has also contributed significant research in this field, notably Things That Think consortium (directed by Hiroshi Ishii, Joseph A. Paradiso and Rosalind Picard) at the Media Lab[10] and the CSAIL effort known as Project Oxygen.[11] Other major contributors include University of Washington‘s Ubicomp Lab (directed by Shwetak Patel), Georgia Tech‘s College of Computing, Cornell University‘s People Aware Computing Lab, NYU‘s Interactive Telecommunications Program, UC Irvine‘s Department of Informatics, Microsoft Research, Intel Research and Equator,[12] Ajou University UCRi & CUS.[13]

One of the earliest ubiquitous systems was artist Natalie Jeremijenko‘s “Live Wire”, also known as “Dangling String”, installed at Xerox PARC during Mark Weiser‘s time there. This was a piece of string attached to a stepper motor and controlled by a LAN connection; network activity caused the string to twitch, yielding a peripherally noticeable indication of traffic. Weiser called this an example of calm technology.[14]

Ambient Devices has produced an “orb”, a “dashboard”, and a “weather beacon“: these decorative devices receive data from a wireless network and report current events, such as stock prices and the weather, like the Nabaztag produced by Violet Snowden.

The Australian futurist Mark Pesce has produced a highly configurable 52-LED LAMP enabled lamp which uses Wi-Fi named MooresCloud after Moore’s Law.[15]

The Unified Computer Intelligence Corporation has launched a device called Ubi – The Ubiquitous Computer that is designed to allow voice interaction with the home and provide constant access to information.[16]

Ubiquitous computing touches on a wide range of research topics, including distributed computing, mobile computing, location computing, mobile networking, context-aware computing, sensor networks, human-computer interaction, and artificial intelligence.

An introduction to the field appropriate for general audiences is Adam Greenfield‘s book Everyware: The Dawning Age of Ubiquitous Computing (ISBN 0-321-38401-6). Greenfield describes the interaction paradigm of ubiquitous computing as “information processing dissolving in behavior”.

Conferences in the field include:

Academic journals and magazines devoted primarily to pervasive computing:

Mark Weiser‘s original material dating from his tenure at Xerox PARC:

Other links:

|

||

|

||

This page was last modified on 24 July 2013 at 14:43.

http://en.wikipedia.org/wiki/Ubiquitous_computing

Där nanovetenskap och medicin möts är det mest fantasin som sätter gränser för det möjliga. Ska blinda kunna se? Lama kunna gå? –Det är de flashiga sidorna av nanomedicin. Det finns mer närliggande angelägna frågor vi har löst innan vi är där, säger Martin Kanje professor i cell- och organismbiologi i Lund.

Sedan länge är hjärnor och datorer ihopkopplade i skön eller skrämmande förening i den värld science fiction-författare skildrar. Men så är det inte i verkligheten. Inte än, men ganska snart om man får tro Martin Kanje och hans kollegor på Neuronanoscience Research Center (NRC) vid Lunds universitet.

Nano är grekiska för dvärg och nanomedicin handlar verkligen om det nästan obegripligt lilla formatet. En nanometer är en miljondels millimeter. De elektroder Martin Kanje arbetar med är ungefär 50 nanometer. Det innebär att om man vill kan hundratals placeras i en enda nervcell. Tekniken att göra så är på gång.

Det lilla formatet innebär att elektroderna ska kunna användas av personer i rörelse, i vardagen. De nanostora elektroderna följer med i hjärnans geléartade rörelser utan att störa.

–Men framför allt blir upplösningen extremt hög och kommunikationen mellan elektroderna som avläser aktiviteten i nervsystemet och omvärlden – till exempel en dator som tolkar signalerna – betydligt mer avancerad än dagens tillämpningar, konstaterar Martin Kanje.

Tanken att elektroniskt styra kroppsliga processer är inte ny.

En pacemaker håller takten åt hjärtat, implantat i örats snäcka ger ljud åt hörselskadade och elektroder i hjärnan dämpar symtomen hos parkinsonsjuka.

Men den gamla tekniken är alltför stor och trubbig för mer sofistikerade tillämpningar i centrala nervsystemet. Med få elektroder blir upplösning för dålig.

Dessutom vill forskarna på NRC inte bara ha envägskommunikation, de vill ha ett samtal mellan nervsystemet och omvärlden. Inte bara stimulering utan också respons.

–Vi vill skapa ett fungerande samspel så att information förmedlas både till och från nervsystemet, säger Martin Kanje.

I ett sådant tvåpartssamtal skulle nervfunktionerna vid många sjukdomar kunna talas till rätta.

Vid kronisk smärta dämpar eller helt blockerar nanoelektroden smärtsignalen i hjärnan. Vid epilepsi, där ett anfall kan liknas vid en elektrisk storm i hjärnan med en mängd nervceller inblandade, skulle en lyssnande elektrod kunna ge en bromssignal som avvärjer anfallet. Vid inkontinens tar elektroderna över den fallerade tömningen av urinblåsan. Tekniken kan också tillämpas så att en handprotes ger en känselupplevelse av vad handen gör.

Exemplen är många. Och i teorin fungerar det.

–Den största utmaningen ligger i att få kopplingen mellan det levande och tekniken att fungera över tid, säger Martin Kanje och jämför den miljö nanoimplantaten ska verka i med att lägga en radioapparat i saltvatten och få den att fortsätta fungera.

För att samtalen ska fortgå måste elektroden fungera i den fientliga miljön och självklart måste nervcellen överleva.

Allt främmande i kroppen kapslas in av inflammatoriska processer. Det skadar både nervcellen och skärmar av elektrodens signal.

–Kanske lösningen finns i fjärilens vinge, säger Martin Kanje. Den är hydrofob. Den blir aldrig blöt, ingenting fastnar på den.

Klär man nanoelektroderna med ett ytskikt som kopierar fjärilsvingens talar mycket för att inte heller immunförsvarets inflammatoriska celler får fäste på den hydrofoba ytan. Tekniker för att modifiera ytor med nanoteknik finns redan.

Ska elektroder i vårt centrala nervsystem på ett mer sofistikerat sätt både ta emot och sända signaler på hjärnans elektriska språk vill det till att formatet är nano. Och att det ska lyckas är det fler än nanoforskarna själva som tror på.

Bland andra svenska Vetenskapsrådet som förra anslog 75-miljoner kronor i så kallade Linnépengar och Knut och Alice Wallenbergs stiftelse med 40 miljoner kronor till NRC.

Kommunikationen utanför kroppen, till exempel med en mottagare/sändare som ligger ien liten urgröpning i skallbenet, är rent tekniskt mer lättlöst.

Men hur blir det med de blinda som kan se och de lama som kan gå?

–Jo, det kommer nog det också, säger Martin Kanje och berättar att det till exempel pågår EU-finansierade försök där näthinnereceptorer som skadats av sjukdom ersätts med ljuskänsliga elektroder.

–Mycket återstår, men jag tror att vi om tio år har tillgång till relativt avancerade implantat ihjärnan, säger Martin Kanje.

Det är trångt i hjärnan, mycket trångt. Och komplext. Hundra miljarder nervceller, var och en av dem med tusentals förbindelser till andra nervceller. Allt detta i en volym på knappt en och en halv liter.

Därför är hjärnan det sista ofullständigt utforskade territoriet i våra kroppar, säger Martin Kanje.

Mitt namn är Karim Jebari, och jag är doktorand i filosofi vid KTH. Min avhandling handlar om tillämpad etik och i synnerhet om hur vi bör förhålla oss till de utmaningar och möjligheter som den teknologiska utvecklingen ställer oss inför.

Jag är intresserad av det mesta som har med politik, etik och filosofi att göra. Mina största intressen just nu är transhumanism, rationell filantropi och existentiella risker.

I fredas skickade jag in min licentiatavhandling till tryckeriet. Den bestå av tre artiklar varav en är publicerad och två andra är inskickade till internationell peer-reviewed press. I tre inlägg framöver tänkte jag sammanfatta innehållet i dessa artiklar.

Artiklarna i den här licenciatavhandlingen utforskar frågor som har att göra med de etiska aspekterna av användningen av hjärnmaskingränssnitt. Ett hjärnmaskingränssnitt möjliggör direkt utbyte av information mellan en hjärna och en maskin. Maskiner med denna funktion har förvisso funnits en längre tid, sedan den första electroencephalografin (EEG) började användas för att registrera och analysera patienters hjärnaktivitet. Men de senaste decennierna har denna teknik utvecklats avsevärt, främst inom sjukvården, och den har även börjat användas inom konsumentelektronik och marknadsföring. Eftersom hjärnmaskingränssnitt ger oss ett nytt sätt att interagera med datorer och maskiner, kan den här teknologin komma att få en stor påverkan på hur det moderna samhället och det mänskliga tillståndet utvecklas. Teknologisk utveckling är till sin natur svår att förutsäga och teknologier som har en potential att revolutionera vår tillvaro måste diskuteras och granskas innan de har förändrat samhället på ett irreversibelt sätt.

I den första artikeln, ”Brain Machine Interface and Human Enhancement – An Ethical Review”, argumenterar jag för att hjärnmaskingränssnitt tillhör den kategorin teknologier som har denna potential. Två trender inom teknikutvecklingen kan sägas påskynda denna process. Den ena är att avancerade datorer blir allt mindre, mer kraftfulla och billigare. Med hjälp av ren beräkningskraft kan mycket mer information från hjänan processas på ett effektivt sätt. Det har gjort att icke-invasiva gränssnitt, alltså sådana som kan användas utan att utsätta användaren för en medicinsk risk, kan användas inom allt fler områden.

De första tankestyrda proteserna krävde en riskabel och dyr operation, där mikroelektroder fästes direkt på hjärnbarken. Moderna proteser kan använda sig av den information som externa elektroder kan fånga upp. De allra senste proteserna har dessutom mjukvara som lär sig sina användares kroppsrörelser och kan därmed vara mer följsam och bekväm.

Den andra trenden är vår allt större kunskap om hjärnan, som möjliggör en mycket mer effektiv användning av hjärnmaskingränssnitt. Cochleaimplantat, hörhjälpmedel som genom elektrisk stimulering av hörselnerven ger gravt hörselskadade och döva barn möjligheten att uppfatta ljud, är förmodligen den mest kända tillämpningen av den här tekniken. Dessa implantat har förbättrats stadigt sedan de introducerades för mer än ett decennium sedan. Mycket av den här förbättringen har berott på just ökade insikter om hörslenervens komplexa anatomi.

Hjärnpacemakers, implantat som genom elektriska impulser stimulerar vissa hjärnregioner, är också en teknologi som utvecklats i en snabb takt det senaste decenniet. Till en början användes dessa hjärnimplantat endast för att motverka symptomen hos svåra neurodegenerativa sjukdomar, som parkinsons sjukdom och dystonia. Numera har även patienter med depression, svåra tvångssyndrom och kronisk smärta nytta av dessa implantat. Förhoppningen inom forskningen på detta område är att kunna stimulera hjärnan på ett liknande sätt utan att behöva utsätta patienten för en invasiv operation.

Om detta skulle bli verklighet kan hjärnpacemakers få en mängd nya användningsområden, eftersom hjärnstimulans har en förmåga att på ett precist och effektivt sätt påverka hjärnaktivitet som vida överträffar psykoaktiva drogers.

Hjärnmaskingränssnitt har tagit steget från att vara en rent medicinsk teknologi, där frågor om patientsäkerhet och djurförsök dominerade den etiska debatten, till att även bli en konsumentprodukt. EEG-baserade dataspelstillbehör säljs idag av minst två konkurrerande aktörer på marknaden. EEG används också för marknadsundersökningar, bland annat för att kartlägga testpublikers reaktioner på reklamfilmer. Denna vändning i teknikutvecklingen gör att nya etiska problem blir relevanta.

Den här artikeln undersöker två områden där ett potentiellt missbruk av hjärnmaskingränssnitt bör leda till vidare granskning och regleringar av denna teknologi. Eftersom hjärnmaskingränssnitt kan extrahera potentiellt mycket privat information om användaren är personlig integritet (eng. ”privacy”) en mycket relevant fråga.

Det bör påpekas att det är inte i nuläget möjligt att ”läsa tankar” med den här typen av teknologi, samt att den här möjligheten ligger långt fram i tiden. Likväl finns idag en trend att arbetsgivare, informationsföretag som Google och Amazon och PR-experter får en allt större insikt i människors beteende och hur de kan påverka det. Smarta kameror med ansiktsigenkänning, mjukvara som sparar personers datoranvändade samt statistiska analysverktyg kan redan idag generara mängder av information om vanliga personer, information som ofta är otillgänglig för allmänheten, och som ibland används för syften som inte gagnar individen. En ökad användning av hjärnmaksingränssnitt skulle innebära att mer sådan information produceras utan användares kännedom eller på sätt som inte är tillräckligt transparenta.

Hjärnmaskingränssnitt har stor potential att ge personer som idag är förlamade, blinda, döva, svårt deprimerade eller kroniskt sjuka en möjlighet att återfå en del av sina förlorade förmågor. I detta avseende kan den här typen av teknologi göra stor skillnad för dessa människors autonomi. Med autonomi menas här en individs möjlighet att utforma sitt liv i enlighet med vad individen själv finner vara goda och riktiga mål. Men det är inte bara sjukdom och skador som kan underminera en persons autonomi. Vissa filosofer har även argumenterat att reklam påverkar vår autonomi negativt, i den mån dess syfte är att påverka våra begär på ett sätt som går vår förnuftiga natur förbi.

I den mån som reklamföretag lär sig alltmer om individers vanor, preferenser och begär ökar rimligen företagens förmåga att påverka dessa. Givet att reklam utgör ett hot mot vår autonomi så kan sofistikerade hjärnmaskingränssnitt öka det här problemet. Men hjärnmaskingränssnitt kan också på ett direkt sätt påverka våra preferenser och begär, med hjälp av elektrisk stimulering av hjärnan. Notera att så länge som elektrisk stimulering förutsätter ett implantat så kommer den här typen av hjärnmaskingränssnitt att sannolikt endast användas av svårt sjuka personer. Skulle ett icke invasivt alternativ utvecklas däremot, finns det vissa möjligheter att dessa skulle kunna användas för att låta personer förändra sina preferenser och begär.

I den mån som vi själva har kontroll över dessa apparater kan vår autonomi öka avsevärt. Men givet att hjärnstimulering är så potent så bör den här möjligheten att vara förbehållen individen själv, annars riskerar vi att få ett samhälle där någon eller några aktörer får otillbörlig makt över andra människors känslor och attityder. Sett ur ett autonomiperspektiv vore detta beklagansvärt.

- See more at: http://politiskfilosofi.com/2012/11/06/sammanfattning-av-min-licentiatavhandling-del-ett-hjarnmaskingranssnitt-idag-och-imorgon/#sthash.A6XFRZkL.dpuf

http://politiskfilosofi.com/2012/11/06/sammanfattning-av-min-licentiatavhandling-del-ett-hjarnmaskingranssnitt-idag-och-imorgon/

Matematik och datormodeller har länge använts inom fysik och kemi, men har nu även börjat användas inom biologisk forskning. Det här är en ny vetenskaplig trend vilken de åtta forskargrupperna på avdelningen för beräkningsbiologi (CB, computational biology) i allra högsta grad är en del av.

Professor Anders Lansner leder forskargruppen Computational Neuroscience and Neurocomputing på CB:

“Det pågår helt klart ett paradigmskifte inom biologin där den kvantitativa aspekten blir mer och mer framträdande. I framtiden kommer datalogi-beräkningsvetenskap och tillämpad matematik vara oerhört viktiga delar av den biologiska forskningen. Vi ser bara början,” säger han.

Forskargruppens huvudsakliga uppgift är att simulera minne och perception hos däggdjurshjärnan. En grundförutsättning för att simuleringarna ska gå att göra är tillgång till kraftfulla datorer, och den nya superdatorn på PDC var därför mycket efterlängtad. Med en så kraftfull superdator går det att simulera hundratals miljoner neuroner och många miljarder synapser, vilket börjar närma sig hjärnbarkens storlek hos ett litet däggdjur.

“Vi arbetar med storskaliga simuleringar och har länge tyckt att datorerna varit för svaga. Nuförtiden känns det inte så längre, vilket är väldigt trevligt eftersom det gör att våra idéer kan bli till verklighet i mycket större utsträckning,” säger Anders Lansner.

Anders började studera perception och minne när han kom till KTH under 80-talet och blev efter några år djupt involverad i modellering av lokomotoriska system tillsammans med neuroforskare på Karolinska Institutet, vilket han ägnade 20 år åt.

“Ja, och vi har under de senaste fem-sex åren återvänt till det här [perception och minne] forskningsområdet. Numera har vi en mycket mer detaljerad modell och mer biologisk data, och kan t ex återskapa oscillationerna i centrala nervsystemet i olika stadier,” säger Anders Lansner.

Forskningen i hans grupp fokuserar på dynamik på nätverksnivå för att försöka förstå vilka egenskaper hos neuroner och synapser som verkligen spelar roll för specifika kognitiva funktioner såsom det makroskopiska fenomenet minne, såsom återkallande av ett minne. Gruppen samarbetar bland annat med neurofysiologer på Karolinska Institutets avdelning för neurovetenskap och minnespsykologer på Stockholms universitet samt är en del av Stockholm Brain Institute (SBI) där Anders Lansner ansvarar för beräknings- och modelleringsplattformen.